In un discorso speciale, rapido e accattivante, tenuto al SIGGRAPH, i dirigenti di NVIDIA hanno descritto le forze che guideranno la prossima era della grafica e la gamma sempre più ampia di strumenti offerti dall’azienda per accelerarle.

“La combinazione di intelligenza artificiale e computer grafica alimenterà l’ metaversola prossima evoluzione di Internet”, ha affermato Jensen Huang, fondatore e CEO di NVIDIA, dando il via al discorso di 45 minuti.

Sarà la sede di mondi virtuali connessi e gemelli digitaliun posto per il vero lavoro e anche per il gioco. E, ha detto Huang, sarà vibrante di quella che diventerà una delle forme più popolari di robot: gli avatar umani digitali.

Con 45 demo e slide, cinque relatori NVIDIA hanno annunciato:

- Una nuova piattaforma per la creazione di avatar, NVIDIA Omniverse Avatar Cloud Engine (ASSO).

- Progetti per la realizzazione della descrizione della scena universale (Dollaro statunitense), il linguaggio del metaverso.

- Estensioni importanti a NVIDIA Omniversola piattaforma informatica per la creazione di mondi virtuali e gemelli digitali.

- Strumenti per potenziare i flussi di lavoro grafici con l’apprendimento automatico.

“Gli annunci che abbiamo fatto oggi fanno progredire ulteriormente il metaverso, una nuova piattaforma informatica con nuovi modelli di programmazione, nuove architetture e nuovi standard”, ha affermato.

Le applicazioni del metaverso sono già qui.

Huang ha fatto riferimento ai consumatori che provano prodotti virtuali 3D con la realtà aumentata, alle compagnie telefoniche che creano gemelli digitali delle loro reti radio per ottimizzare e implementare le torri radio e alle aziende che creano gemelli digitali di magazzini e fabbriche per ottimizzare la loro disposizione e logistica.

Entrano gli Avatar

Il metaverso prenderà vita con assistenti virtuali, avatar con cui interagiremo in modo naturale come se parlassimo con un’altra persona. Lavoreranno in fabbriche digitali, giocheranno nei giochi online e forniranno assistenza clienti per i rivenditori online.

“Ci saranno miliardi di avatar”, ha detto Huang, definendoli “uno dei tipi di robot più ampiamente utilizzati” che saranno progettati, addestrati e gestiti in Omniverse.

Gli esseri umani digitali e gli avatar necessitano di elaborazione del linguaggio naturale, visione artificiale, animazioni complesse del viso e del corpo e altro ancora. Per muoversi e parlare in modo realistico, questa serie di tecnologie complesse deve essere sincronizzata al millisecondo.

È un duro lavoro che NVIDIA intende semplificare e accelerare con Omniverse Avatar Cloud Engine. ASSO è una raccolta di modelli e servizi di intelligenza artificiale che si basano sul lavoro di NVIDIA e spaziano dall’intelligenza artificiale conversazionale agli strumenti di animazione come Audio2Face e Audio2Emotion.

Immagine di MetaHuman in Unreal Engine per gentile concessione di Epic Games.

“Con Omniverse ACE, gli sviluppatori possono creare, configurare e distribuire la loro applicazione avatar su qualsiasi motore in qualsiasi cloud pubblico o privato”, ha affermato Simon Yuen, direttore senior di grafica e IA presso NVIDIA. “Vogliamo democratizzare la creazione di avatar interattivi per ogni piattaforma”.

ACE sarà disponibile all’inizio del prossimo anno e funzionerà su sistemi embedded e su tutti i principali servizi cloud.

Yuen ha anche presentato l’ultima versione di Omniverse Audio2Face, un modello di intelligenza artificiale in grado di creare animazioni facciali direttamente dalle voci.

“Abbiamo appena aggiunto altre funzionalità per analizzare e trasferire automaticamente le tue emozioni al tuo avatar”, ha affermato.

Le versioni future di Audio2Face creeranno avatar da una singola foto, applicando automaticamente le texture e generando mesh 3D pronte per l’animazione. Saranno dotate di simulazioni ad alta fedeltà dei movimenti muscolari che un’IA può apprendere guardando un video, persino capelli realistici che rispondono come previsto alla toelettatura virtuale.

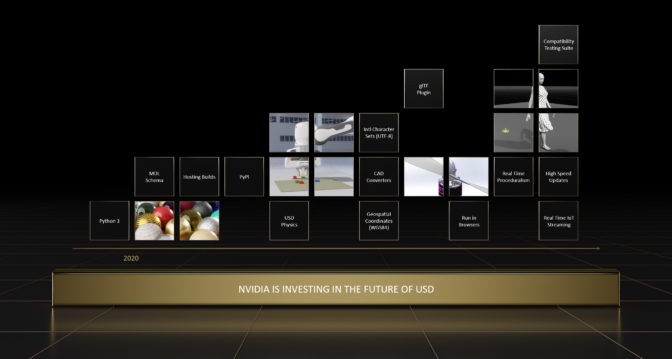

USD, una fondazione per Internet 3D

Molte superpotenze del metaverso saranno basate sull’USD, una base per Internet 3D.

Il metaverso “ha bisogno di un modo standard per descrivere tutte le cose nei mondi 3D”, ha affermato Rev Lebaredian, vicepresidente di Omniverse e della tecnologia di simulazione presso NVIDIA.

“Riteniamo che la descrizione universale delle scene, inventata e resa open source dalla Pixar, sia la descrizione standard delle scene per la prossima era di Internet”, ha aggiunto, paragonando USD a HTML nel web 2D.

Lebaredian ha descritto la visione di NVIDIA per Dollaro statunitense come chiave per aprire ancora più opportunità di quelle presenti nel mondo fisico.

“I nostri prossimi traguardi puntano a rendere USD performante per mondi virtuali su larga scala e in tempo reale e gemelli digitali industriali”, ha affermato, sottolineando i piani di NVIDIA di contribuire a sviluppare il supporto in USD per set di caratteri internazionali, coordinate geospaziali e streaming in tempo reale di dati IoT.

Per accelerare ulteriormente l’adozione di USD, NVIDIA rilascerà una suite di test e certificazione di compatibilità per USD. Ciò consente agli sviluppatori di sapere che i loro componenti USD personalizzati producono un risultato previsto.

Inoltre, NVIDIA ha annunciato un set di asset USD pronti per la simulazione, progettati per l’uso in gemelli digitali industriali e flussi di lavoro di formazione AI. Si uniscono a una vasta gamma di Risorse USD disponibile online gratuitamente, comprese scene pronte per USD, tutorial su richiesta, documentazione e corsi tenuti da istruttori.

“Vogliamo che tutti contribuiscano a costruire e far progredire l’USD”, ha affermato Lebaredian.

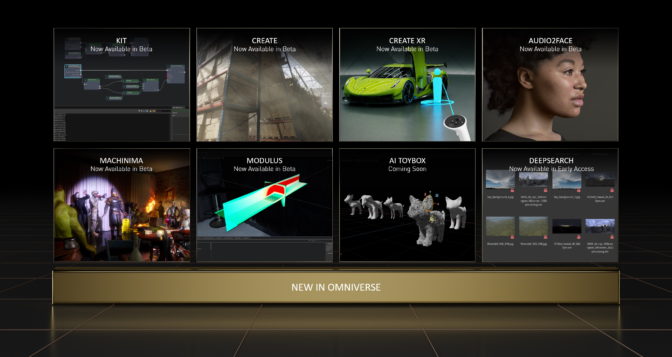

Omniverse amplia la sua tavolozza

Uno degli annunci più importanti del discorso speciale è stata una nuova importante pubblicazione di NVIDIA Omniversouna piattaforma che è stata scaricata quasi 200.000 volte.

Huang ha definito Omniverse “una piattaforma USD, un toolkit per la creazione di applicazioni metaverse e un motore di calcolo per gestire mondi virtuali”.

L’ultima versione include numerose tecnologie di base aggiornate e maggiori connessioni agli strumenti più diffusi.

I collegamenti, chiamati Connettori Omniversesono ora in fase di sviluppo per Unity, Blender, Autodesk Alias, Siemens JT, SimScale, Open Geospatial Consortium e altro. I connettori sono ora disponibili in versione beta per PTC Creo, Visual Components e SideFX Houdini. Questi nuovi sviluppi si uniscono Siemens Xceleratorora fa parte della rete Omniverse, accogliendo un numero sempre maggiore di clienti industriali nell’era dei gemelli digitali.

Come Internet stessa, Omniverse è “una rete di reti” che collega utenti di diversi settori e discipline, ha affermato Steve Parker, vicepresidente della grafica professionale di NVIDIA.

Quasi una dozzina di aziende leader presenteranno le capacità di Omniverse al SIGGRAPH, tra cui fornitori di hardware, software e servizi cloud che vanno da AWS e Adobe a Dell, Epic e Microsoft. Una mezza dozzina di aziende condurrà sessioni basate su NVIDIA su argomenti come AI e mondi virtuali.

Accelerare la fisica, animare gli animali

Parker ha descritto in dettaglio diversi aggiornamenti tecnologici in Omniverse. Essi comprendono miglioramenti per la simulazione di materiali fisicamente accurati con il Material Definition Language (MDL), fisica in tempo reale con FisicaX e il sistema ibrido di rendering e intelligenza artificiale, RTX.

“Questi pilastri tecnologici fondamentali sono alimentati dal calcolo ad alte prestazioni NVIDIA dall’edge al cloud”, ha affermato Parker.

Ad esempio, PhysX ora supporta la simulazione soft-body e partition-cloth, portando una maggiore accuratezza fisica ai mondi virtuali in tempo reale. E NVIDIA sta rendendo MDL completamente open source, quindi può supportare facilmente standard API grafici come OpenGL o Vulkan, rendendo lo standard dei materiali più ampiamente disponibile agli sviluppatori.

Omniverse includerà anche capacità di grafica neurale sviluppate da NVIDIA Research che combinano grafica RTX e AI. Ad esempio:

- Gli Animal Modelers consentono agli artisti di riprodurre la forma di un animale tramite nuvole di punti, per poi generare automaticamente una mesh 3D.

- GauGAN360la prossima evoluzione di NVIDIA GauGANgenera panorami 8K a 360 gradi che possono essere facilmente caricati in una scena Omniverse.

- NeRF istantaneo crea oggetti e scene 3D da immagini 2D.

UN Estensione Omniverso per Modulo NVIDIAun framework di apprendimento automatico consentirà agli sviluppatori di utilizzare l’intelligenza artificiale per accelerare le simulazioni della fisica del mondo reale fino a 100.000 volte, in modo che il metaverso appaia e venga percepito come il mondo fisico.

Inoltre, Machinima dell’Omniverso — oggetto di un concorso vivace su SIGGRAPH — ora contenuti sportivi da Dopo aver scritto, Oltre il filo E Guerriero Ombra 3 così come nuovi strumenti di animazione AI come Audio2Gesture.

Una demo di Industrial Light & Magic ha mostrato un’altra nuova funzionalità. Ricerca profonda di Omniverse utilizza l’intelligenza artificiale per aiutare i team a effettuare ricerche intuitive in enormi database di risorse non contrassegnate, ottenendo risultati accurati per i termini anche quando non sono specificatamente elencati nei metadati.

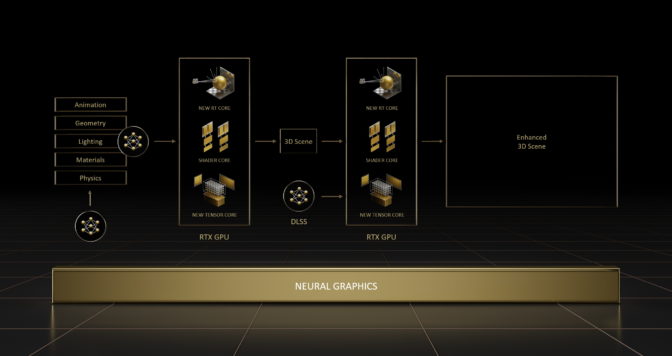

La grafica diventa intelligente

Uno dei pilastri essenziali del metaverso emergente è grafica neuraleÈ una disciplina ibrida che sfrutta modelli di reti neurali per accelerare e migliorare la computer grafica.

“La grafica neurale intreccia AI e grafica, aprendo la strada a una futura pipeline grafica che è adatta all’apprendimento dai dati”, ha affermato Sanja Fidler, vicepresidente AI di NVIDIA. “La grafica neurale ridefinirà il modo in cui i mondi virtuali vengono creati, simulati e vissuti dagli utenti”, ha aggiunto.

L’intelligenza artificiale aiuterà gli artisti a generare l’enorme quantità di contenuti 3D necessari per creare il metaverso. Ad esempio, possono usare la grafica neurale per catturare rapidamente oggetti e comportamenti nel mondo fisico.

Fidler ha descritto il software NVIDIA come un modo per fare proprio questo, NeRF istantaneouno strumento per creare un oggetto o una scena 3D da immagini 2D. È l’oggetto di uno dei due premi per i migliori articoli di NVIDIA al SIGGRAPH.

Nell’altro premio per il miglior articolo, la grafica neurale alimenta un modello in grado di prevedere e ridurre le latenze di reazione negli eSport e nelle applicazioni AR/VR. I due migliori articoli sono tra i 16 totali che i ricercatori NVIDIA presenteranno questa settimana al SIGGRAPH.

I progettisti e i ricercatori possono applicare la grafica neurale e altre tecniche per creare il proprio lavoro pluripremiato utilizzando nuovi kit di sviluppo software NVIDIA ha presentato all’evento.

Fidler ne ha descritto uno, Filamento di caolinouna serie di strumenti per creare campi neurali, ovvero modelli di intelligenza artificiale che rappresentano una scena o un oggetto 3D, con solo poche righe di codice.

Separatamente, NVIDIA ha annunciato NeuralVDBla prossima evoluzione dello standard open source OpenVDB che settori che vanno dagli effetti visivi all’informatica scientifica utilizzano per simulare e riprodurre acqua, fuoco, fumo e nuvole.

NeuralVDB sfrutta modelli neurali e l’ottimizzazione della GPU per ridurre drasticamente i requisiti di memoria, così gli utenti possono interagire con set di dati estremamente grandi e complessi in tempo reale e condividerli in modo più efficiente.

“L’intelligenza artificiale, la forza tecnologica più potente del nostro tempo, rivoluzionerà ogni campo dell’informatica, inclusa la computer grafica, e NVIDIA RTX è il motore della grafica neurale”, ha affermato Huang.

Guarda il discorso speciale completo al SIGGRAPH di NVIDIA sito dell’eventoQui troverete anche i dettagli dei laboratori, delle presentazioni e il debutto di un documentario dietro le quinte su come abbiamo creato il nostro ultimo keynote GTC.